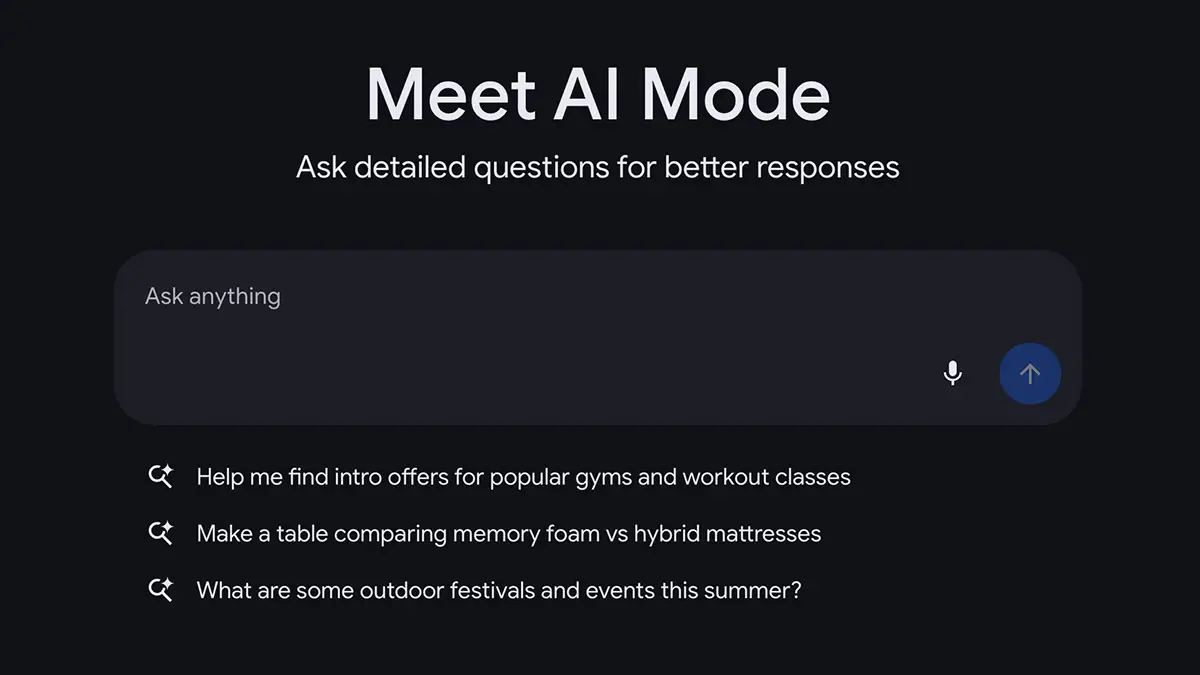

La conférence Google I/O de mai 2025 a marqué un point de non-retour dans l’histoire d’Internet. En activant par défaut le « Mode IA » sur son moteur de recherche, Google a cessé d’être un simple indexeur de liens pour devenir un moteur de réponses conversationnel. Cette mutation, pilotée par le modèle Gemini 2.5, ne change pas seulement l’interface utilisateur : elle bouleverse l’économie numérique, la découverte de contenus et la relation entre l’internaute et l’information. En 2026, cette interface est devenue la norme, reléguant la liste de liens bleus au rang d’archive.

L’essentiel

- Le basculement vers la réponse synthétique : Google ne se contente plus de diriger vers des sites tiers, il génère des réponses complètes et résumées directement en haut de page (AI Overviews).

- L’intégration de Gemini 2.5 : Ce modèle multimodal permet au moteur de « raisonner » sur des requêtes complexes, incluant texte, vidéo et contexte personnel.

- La fusion des données personnelles et publiques : Avec la fonction « Ask Photos », la recherche interroge simultanément le web et la galerie privée de l’utilisateur.

- Un impact critique sur les éditeurs : La baisse du trafic sortant vers les sites web force les créateurs de contenu à repenser leur modèle économique.

- L’unification de l’écosystème : De Maps à Shopping, toutes les verticales sont désormais interconnectées par une intelligence artificielle transversale.

Comprendre cette transformation exige de dépasser la simple nouveauté technique. C’est une redéfinition de l’architecture du web où l’exploration cède la place à l’obtention immédiate, soulevant des questions majeures sur la provenance et la pluralité de l’information.

De l’indexation à la conversation : le rôle de Gemini 2.5

Le cœur de cette révolution porte un nom : Gemini. Dans sa version 2.5, ce modèle de langage a permis à Google de franchir le mur de la complexité sémantique. Auparavant, une recherche nécessitait souvent de fragmenter sa pensée en mots-clés. Aujourd’hui, le moteur traite des demandes structurées, nuancées et multimodales. Il ne s’agit plus de chercher « réparation vélo », mais de demander : « Analyse cette vidéo de mon dérailleur et explique-moi pourquoi il fait ce bruit, puis trouve un réparateur ouvert maintenant à moins de 5 km ».

Cette capacité de raisonnement transforme la page de résultats. Les « AI Overviews » occupent l’espace visuel principal, fournissant une synthèse digeste agrégée à partir de multiples sources. Si cela représente un gain de temps indéniable pour l’utilisateur, cela modifie radicalement la visibilité des sources primaires, qui se retrouvent souvent reléguées sous la ligne de flottaison.

La recherche multimodale et l’extension « Ask Photos »

L’une des avancées les plus spectaculaires réside dans l’effacement de la frontière entre les données du web et les données personnelles. La fonctionnalité « Ask Photos » illustre parfaitement cette hybridation. L’utilisateur peut interroger le moteur sur sa propre vie avec la même facilité qu’il interroge Wikipédia.

En posant une question telle que « Où avons-nous mangé lors de notre voyage à Tokyo l’an dernier et quel était le prix du menu ? », l’IA scanne la galerie photos, identifie le lieu via la géolocalisation, lit le menu pris en photo via Google Lens, et croise ces informations avec les avis publics du restaurant sur Maps. Cette profondeur d’analyse, qui nécessite une puissance de calcul phénoménale (souvent déportée sur les puces Tensor des smartphones Pixel), ancre l’utilisateur dans l’écosystème Google de manière quasi définitive.

Les répercussions sur l’économie du web

Le déploiement massif du Mode IA a provoqué une onde de choc chez les éditeurs de sites web et les créateurs de contenu. Le modèle historique du « donnant-donnant » — Google indexe le contenu et renvoie du trafic en échange — est rompu. Lorsque l’IA fournit la réponse complète sans nécessiter de clic, le site source perd son audience et, par extension, ses revenus publicitaires.

Google défend cette approche en affirmant qu’elle qualifie mieux le trafic restant, mais la réalité de 2026 montre une concentration accrue de l’attention au sein de l’interface du moteur. Les règles du SEO (Search Engine Optimization) ont dû être réécrites : il ne s’agit plus seulement d’être premier dans une liste, mais d’être la source citée par l’IA dans sa synthèse, un défi technique qui favorise les contenus ultra-structurés et les marques à forte autorité.

FAQ

Google a intégré l’IA comme composante native de son moteur. S’il existe un filtre « Web » permettant d’afficher uniquement des liens textuels, l’expérience par défaut reste centrée sur les réponses génératives (AI Overviews), considérées par la firme comme la nouvelle norme de recherche.

Google assure que les données personnelles analysées par Gemini dans le cadre de « Ask Photos » ne sont pas utilisées pour cibler la publicité. Le traitement est majoritairement effectué de manière cloisonnée, et les informations issues de vos photos ne sont pas mélangées avec l’index public du web.

Si la recherche web générative est accessible sur tout navigateur, les fonctions avancées d’analyse locale et multimodale (comme sur les vidéos en temps réel) nécessitent des processeurs dotés d’unités de traitement neuronal (NPU) puissantes, comme les puces Google Tensor G5 ou les derniers processeurs Snapdragon et Apple Silicon.