L’intelligence artificielle ne se limite plus à des modules périphériques : elle constitue désormais le noyau dur de Photoshop 2026 (v27.0). De la sélection prédictive au masquage global, les algorithmes Sensei et Firefly restructurent les flux de production. Adobe impose cette année une IA utilitaire, conçue pour abattre les tâches répétitives sans jamais déposséder l’utilisateur de ses choix créatifs.

L’Essentiel

- Automatisation ciblée : l’IA gère les sélections et masquages complexes pour libérer du temps de création.

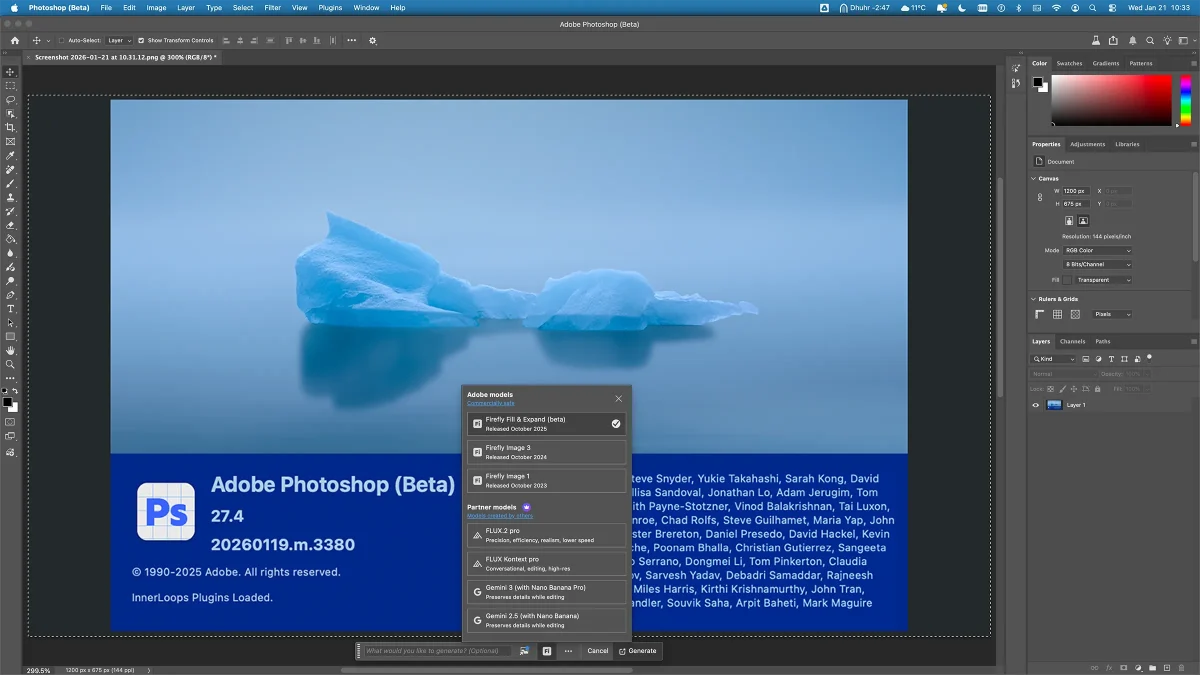

- Architecture hybride : les outils de sélection tournent en local (NPU), tandis que la génération complexe exploite le cloud.

- Preuve par l’image : le détourage par IA est jusqu’à 20 fois plus rapide que les outils historiques.

- Sécurité du flux : les filtres neuronaux et masques générés restent totalement non destructifs.

- Arbitrage humain : l’algorithme propose une base technique, l’expert valide la nuance artistique.

Une intelligence artificielle intégrée au moteur

L’intégration de l’IA dans Photoshop marque le passage d’une analyse technique (pixels, contraste) à une lecture sémantique. Le moteur ne voit plus seulement des nuances de gris ; il identifie des entités cohérentes : un visage, une texture végétale, une structure architecturale.

Cette rupture repose sur une architecture hybride. En 2026, les tâches de détection (Sensei) s’exécutent localement sur les processeurs neuronaux (NPU), garantissant une réactivité immédiate. À l’inverse, les tâches de création pure (Firefly) sollicitent la puissance du cloud. Cette distinction est cruciale : elle assure que l’outil de sélection reste fluide, même sur des fichiers lourds.

Sélection d’objets : la fin du détourage manuel

L’outil « Sélection d’objets » impose un nouveau paradigme de productivité. Le simple survol de la souris déclenche une prévisualisation immédiate du masque. Un clic suffit pour verrouiller une sélection que la « Plume » aurait mis plusieurs minutes à tracer.

La force de la version 2026 réside dans sa gestion des micro-contrastes. Sur des zones historiquement critiques — cheveux volants, fumée, transparences — l’IA fournit une base de travail exploitable à 95 %. L’utilisateur n’intervient plus que pour l’arbitrage final, transformant une corvée technique en une simple validation.

Comparatif d’efficacité

| Méthode | Précision des bords | Temps moyen (Sujet complexe) | Intervention manuelle |

| Baguette Magique (Legacy) | Faible (basée sur le contraste) | 2 à 5 minutes | Très élevée |

| Sélection Rapide | Moyenne (peinture de zone) | 1 à 2 minutes | Moyenne |

| Sélection d’objet (IA) | Élevée (détection sémantique) | < 10 secondes | Faible |

Masquer tous les objets : l’approche par couches logiques

La commande « Masquer tous les objets » (Mask All Objects) automatise la déconstruction de l’image. En une opération, Photoshop analyse la scène et isole chaque élément détecté sur un calque distinct, assorti de son masque de fusion.

Cette fonctionnalité modifie l’organisation même du travail de retouche. L’image devient un assemblage modulaire où chaque composant peut être ajusté indépendamment (colorimétrie, courbes, flou). Pour les professionnels du compositing, cette approche supprime les étapes fastidieuses de préparation. On ne perd plus de temps à isoler le sujet du fond ; on passe directement à l’étalonnage et à l’harmonie visuelle.

Filtres neuronaux : l’expérimentation sécurisée

Les Neural Filters représentent le laboratoire créatif de Photoshop. Contrairement aux filtres destructifs du passé, ils agissent comme des calques intelligents (Smart Filters) capables de modifier l’âge d’un sujet, la direction de la lumière ou la saison d’un paysage.

Leur valeur ajoutée est exploratoire. Ils permettent de proposer trois ou quatre intentions artistiques à un client en quelques minutes, sans engager un travail de reconstruction lourd. C’est un outil d’itération rapide : on teste, on dose l’effet via les curseurs, et on revient en arrière instantanément si le résultat ne convient pas.

Conseil pro : optimiser le matériel pour l’IA

L’efficacité de ces outils dépend étroitement du matériel. En 2026, l’activation des fonctions de sélection au survol sollicite massivement le GPU et les cœurs dédiés à l’IA.

- Processeur : privilégiez les puces intégrant un NPU (Neural Processing Unit) actif.

- Mémoire vidéo : 8 Go de VRAM sont devenus le standard minimal pour éviter les latences lors de la détection d’objets sur des fichiers haute résolution.

- Préférences : vérifiez dans Édition > Préférences > Traitement de l’image que le traitement est bien réglé sur « Plus rapide » (Device) plutôt que « Plus détaillé » (Cloud) pour les tâches courantes de sélection.

FAQ

Oui, pour l’essentiel. Les outils de sélection d’objets et de masquage rapide tournent en local sur les machines récentes. Seuls les filtres génératifs (remplissage complexe, Neural Filters lourds) exigent un accès au cloud Adobe.

Jamais. Adobe maintient une approche non destructive : les masques générés sont des masques de fusion classiques, modifiables au pinceau, et les filtres s’appliquent dynamiquement.

Lorsqu’une fonction s’exécute en local (Sélection d’objets), aucune donnée ne quitte votre poste. Pour les fonctions cloud (Firefly), Adobe garantit que les images ne sont pas utilisées pour l’entraînement des modèles publics par défaut (version Enterprise).