ChatGPT est un tuteur IA révolutionnaire qui pourrait changer la façon dont nous utilisons la technologie pour apprendre et rechercher des informations. Cependant, il existe également un risque de désinformation. Apprenez-en plus sur ce développement passionnant et potentiellement risqué.

Ce mois-ci, Jeremy Howard, un chercheur en IA, a montré à sa fille de 7 ans un chatbot en ligne appelé ChatGPT. OpenAI, l’un des laboratoires d’IA les plus ambitieux au monde, avait lancé ChatGPT quelques jours auparavant.

Sa fille a pu poser toutes les questions qu’elle voulait au chatbot expérimental, et elle s’est empressée de demander l’utilité de la trigonométrie, l’origine des trous noirs et la raison pour laquelle les poules couvent leurs œufs. ChatGPT a toujours fourni des réponses grammaticalement correctes et logiquement cohérentes. Il a même proposé un programme capable de calculer la trajectoire d’une balle lancée lorsqu’on lui a demandé de le faire.

Dans les jours qui ont suivi, M. Howard en est venu à considérer ChatGPT comme une nouvelle forme de tutorat privé. Sa fille pouvait l’utiliser pour apprendre non seulement les mathématiques et les sciences, mais aussi l’anglais et d’autres matières. L’une des plus importantes est celle-ci : tout remettre en question.

« C’est passionnant de la voir apprendre », s’est-il exclamé. Cependant, je l’ai mise en garde contre le fait de « ne pas croire tout ce qu’il vous dit ». Il a le potentiel de se tromper ».

Il existe de nombreuses organisations et personnes engagées dans le développement de chatbots supérieurs, OpenAI inclus. Dans de nombreux cas, ces machines donnent l’impression d’une conversation humaine alors qu’elles sont incapables de le faire réellement.

Les informations peuvent être récupérées et réorganisées à des vitesses dépassant largement celles des êtres humains. On peut les comparer à des assistants numériques comme Siri ou Alexa, mais avec une capacité accrue à déduire vos intentions et à fournir les résultats souhaités.

Avec le succès de ChatGPT (qui a été téléchargé plus d’un million de fois), de nombreux observateurs du secteur pensent que les chatbots de ce type remplaceront bientôt les moteurs de recherche traditionnels comme Google et Bing.

Au lieu d’une longue liste de liens bleus, ils peuvent fournir des informations sous forme de phrases concises. Les idées sont décomposées en morceaux gérables et présentées d’une manière accessible. En plus de fournir des informations, il peut également imaginer des concepts totalement originaux pour des plans d’affaires, des mémoires et d’autres projets.

L’un des nombreux PDG de la Silicon Valley qui étudient l’impact des chatbots est Aaron Levie, de Box, qui a fait remarquer : « Vous avez maintenant un ordinateur qui peut répondre à n’importe quelle question d’une manière qui a du sens pour un humain. » « Il peut généraliser et combiner des concepts issus de différents domaines. »

Les derniers chatbots semblent confiants dans leurs capacités à le faire. Pourtant, ils peuvent être peu fiables dans leurs déclarations. Ils ne peuvent même pas faire correctement des mathématiques de base parfois. Il y a un mélange de faits et de fiction dans leurs écrits. De plus, à mesure qu’ils progressent, les gens peuvent trouver des moyens de les utiliser pour créer et diffuser de fausses informations.

LaMDA, abréviation de Language Model for Dialogue Applications, est un nouveau système axé sur la conversation développé par Google. L’un des ingénieurs de Google a même suggéré qu’il avait une conscience au printemps dernier. Même si ce n’était pas le cas, les gens s’y sont intéressés de près.

Le spécialiste des données Aaron Margolis, d’Arlington, en Virginie, a été l’un des rares, en dehors de Google, à avoir accès à LaMDA par le biais de l’application expérimentale de la société, AI Test Kitchen. La capacité à avoir des discussions approfondies n’a jamais cessé de l’étonner. L’émission l’a amusé. Cependant, il a noté qu’il était possible que le système soit quelque peu fabuliste, comme on pourrait s’y attendre d’un système enseigné avec les quantités massives de données disponibles sur Internet.

Lorsqu’on lui a demandé de décrire l’expérience, il l’a comparée à un film d’Aaron Sorkin. Le scénario de M. Sorkin, « The Social Network », a été critiqué pour ses prétendues inexactitudes concernant la création de Facebook. Il y aura du vrai et du faux dans ce film.

Récemment, il a contacté LaMDA et ChatGPT, se faisant passer pour Mark Twain dans les deux conversations. Lorsqu’il s’est renseigné, LaMDA a raconté une rencontre entre Twain et Levi Strauss, révélant que l’auteur avait travaillé pour le magnat des bluejeans lors de son séjour à San Francisco au milieu des années 1800. Cela avait du sens et semblait authentique. En fait, ce n’était pas du tout le cas. Bien qu’ils aient tous deux élu domicile à San Francisco, Twain et Strauss n’ont jamais collaboré.

Le terme scientifique pour cet état est « hallucination ». Les chatbots sont comme des conteurs de talent : ils peuvent prendre ce qu’ils ont appris et le transformer en quelque chose de complètement nouveau, quelle que soit la vérité.

Les chercheurs dans le domaine de l’intelligence artificielle appellent LaMDA, un système mathématique vaguement basé sur le réseau de neurones du cerveau, un réseau neuronal. C’est cette même technologie qui permet à des services comme Google Translate de traduire le français et l’anglais, et qui est également utilisée pour reconnaître les piétons lorsque des véhicules autonomes traversent des zones urbaines.

La compétence est acquise par un réseau neuronal grâce à l’examen des données. Il peut apprendre à identifier un chat, par exemple, en analysant des milliers de photos de chats à la recherche de points communs.

Au cours des cinq dernières années, les chercheurs de Google et d’autres laboratoires comme OpenAI ont développé des réseaux neuronaux qui analysent de grandes quantités de textes numériques tels que des livres, des articles de Wikipédia, des articles d’actualité et des journaux de discussion en ligne.

Pour les chercheurs, ces systèmes sont des « grands modèles de langage ». Ces programmes ont appris à générer du texte par eux-mêmes en reconnaissant des milliards de modèles uniques dans la façon dont les gens relient les mots, les chiffres et les symboles.

Les chercheurs qui les ont construits ont été étonnés par leur capacité à générer du langage, tout comme bon nombre de leurs pairs dans ce domaine. Le logiciel était capable de simuler l’écriture humaine et de fusionner des idées sans rapport entre elles. Si vous le lui demandiez, il créerait un épisode de « Seinfeld » dans lequel Jerry est exposé à un algorithme mathématique appelé « tri à bulles ».

OpenAI a travaillé à l’amélioration de ChatGPT. Il n’est pas aussi bon pour la conversation naturelle que LaMDA de Google. Comme d’autres assistants numériques tels que Siri et Alexa, il a été conçu pour être facile à utiliser. ChatGPT, comme LaMDA, a été formé à partir d’une montagne de textes numériques provenant d’Internet.

Le système demandait des évaluations de ses performances à mesure que les utilisateurs le mettaient à l’épreuve. N’ont-ils pas réussi à vous convaincre ? Étaient-ils bons ? Ont-ils été honnêtes ? Les évaluations ont ensuite été utilisées par un processus appelé apprentissage par renforcement pour affiner le système et définir plus précisément ses comportements autorisés et interdits.

Mira Murati, directrice de la technologie d’OpenAI, s’est exprimée en ces termes : « Cela nous permet d’arriver au point où le modèle peut interagir avec vous et admettre quand il a tort ». Une question ou une prémisse incorrecte peut être contestée, et les éléments inappropriés peuvent être rejetés.

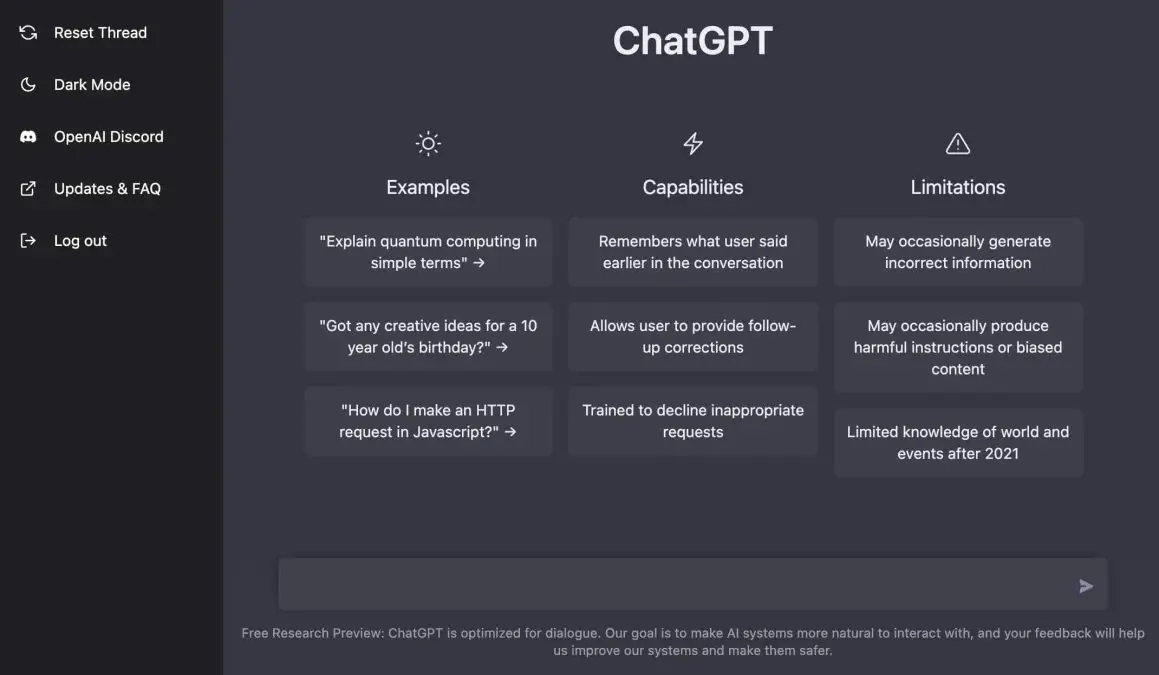

La procédure a définitivement ses défauts. ChatGPT « peut occasionnellement générer des informations incorrectes » et « peut produire des instructions nuisibles ou du contenu biaisé », a prévenu OpenAI à ses utilisateurs. Toutefois, l’entreprise s’engage à poursuivre le développement de la technologie et encourage les utilisateurs à la considérer comme telle.

Des entreprises comme Google et Meta travaillent également à améliorer leur précision. Après que Galactica, un chatbot développé par Meta, ait produit des résultats biaisés et inexacts lors d’une démonstration en ligne, la société a décidé de le retirer.

Les autorités ont prévenu les entreprises qu’elles ne pouvaient pas influencer le développement de ces technologies. Les idées, les documents de recherche et le code informatique de systèmes tels que ChatGPT, LaMDA et Galactica ont tous été librement partagés avec le public pendant des années.

Google et OpenAI sont deux entreprises qui disposent des ressources nécessaires pour faire progresser la technologie plus rapidement que leurs concurrents. Leurs dernières innovations, cependant, ont été largement reproduites et diffusées. Elles n’ont aucun moyen d’empêcher les gens d’utiliser ces canaux pour propager des faussetés.

M. Howard avait espéré que la société dans son ensemble apprendrait à ses enfants à ne pas croire aveuglément tout ce qu’ils lisent en ligne, tout comme il l’avait appris à sa propre fille.

Des millions de ces robots pourraient être programmés pour agir comme des humains et engager des conversations dans le but de persuader leurs homologues humains d’adopter un point de vue particulier, a-t-il ajouté. Cela fait des années que je tire la sonnette d’alarme à ce sujet. C’est une fatalité depuis un certain temps déjà.